【paper reading】A Closer Look at Few-shot Classification

一句话总结

本文研究了骨干网络的能力、数据集领域差异对现有小样本学习方法性能的影响,并强调了现有小样本学习方法的领域自适应能力普遍较差,需要多加注意。

论文信息

- 作者:Wei-Yu Chen, Yen-Cheng Liu, Zsolt Kira, Yu-Chiang Frank Wang, Jia-Bin Huang

- 出处:ICLR 2019

- 机构:CMU; Georgia Tech; National Taiwan University; Virginia Tech

- 关键词:few-shot learning, domain shift, domain adaptation

- 论文链接

- 开源代码:wyharveychen/CloserLookFewShot

- 其他资料:

内容简记

背景与主要贡献

尽管小样本学习(Few-Shot Learning, FSL)近年来有很大的进展,但各种方法实现上的细节差异掩盖了相对表现增益,缺少在同一框架下进行公平的比较。例如,是否在数据增强的情况下进行训练(意思是简单的数据增强能够大幅提高 baseline 的效果)。本文有三个主要贡献:

- 本文对于几种代表性的小样本分类算法进行分析,特别实验了基础骨干网络对这些方法的影响。结果表明,更深的骨干网络(即特征提取能力越强),在领域差异有限的数据集上,显著降低了方法之间的性能差异;

- 本文建立了两个 baseline,其中一种基于距离的分类 baseline 能够在 mini-ImageNet 和 CUB 数据集上与 SOTA 方法相媲美;

- 虽然目前的评估侧重于识别具有有限训练样例的新类,但这些新类从同一数据集中采样。而在现实中,新类和基础类通常存在领域漂移(domain shift)问题。因此,本文强调了小样本学习任务中的领域自适应问题。设置了评估 FSL 算法的跨域泛化能力的实验,其中,基础类和新类别从不同领域中采样。实验表明,目前的 FSL 分类 SOTA 算法在领域漂移的情况下表现相当不好,效果甚至比 baseline 要差,从而表明 FSL 中学习适应领域差别的重要性。

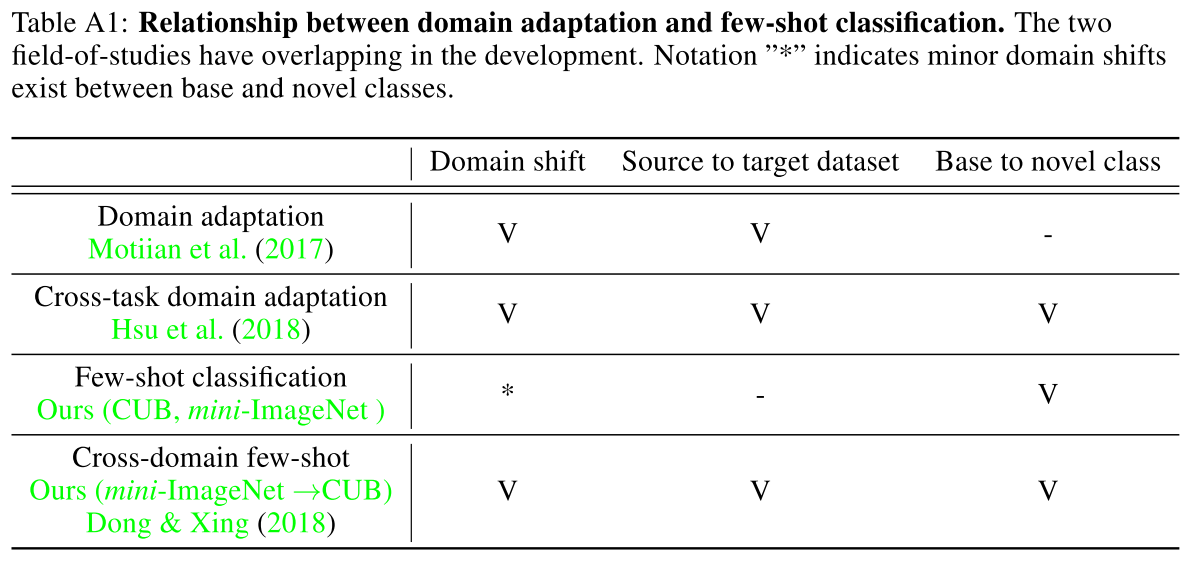

领域自适应(domain adaptation)

前文提到的有关领域的相关概念可能在迁移学习领域更为常见。领域(domain)主要由两部分组成:数据和生成这些数据的概率分布。而领域漂移(domain shift)指的就是源域和目标域的数据分布差异较大。领域自适应(domain adaptation)就是旨在解决领域漂移问题的研究内容。

在本文提到的场景中,领域自适应和小样本分类的区别:

- 领域自适应:旨在将源数据集的知识迁移到目标数据集的相同类别上;

- 小样本分类:从基础类学习去分辨同一数据集的新类。

如果基础类和新类都来自同一数据集,则基础类和新类之间存在的领域漂移极少。

方法

本文提出的 Baseline 和 Baseline++:

在 Baseline++ 中,权重矩阵 $\mathbf{W}_{b} \in \mathbb{R}^{d \times c}$ 可以被分为 $c$ 个 $d$ 维向量,每个向量表示一个类。在训练阶段,每一个输入特征,与 $c$ 个 $d$ 维向量计算 cos 相似度,之后用一个 softmax 函数对相似度进行 normalization。因此,分类结果选取相似度最大的权重向量所代表的类。因此,学到的权重向量可以看作每一类的 prototype,而分类器基于输入特征与学到的 prototype 的距离来运作。softmax 函数可防止学到的权重向量变为零向量。

Baseline++ 显著减少了类内(intra-class)变化性。当然,更深的骨干网络也能做到这一点。

对比的方法包括 MatchingNet、ProtoNet、RelationNet、MAML:

实验

三个场景对应的数据集:

- 通用对象识别:mini-ImageNet;

- 细粒度图像分类:CUB-200-2011;

- 跨域自适应:mini-ImageNet (base class) -> CUB (novel class)。

对比实验

对比各方法在对应的论文公布的结果和本文作者实现的结果:

带*号的是没有进行数据增强的 Baseline。带#号指 way 数更多的 PropoNet。可以看到,数据增强能够有效缓解 Baseline 的过拟合,从而提升效果。

在 mini-ImageNet 和 CUB 数据集上的实验结果:

可以看到,Baseline++ 可以与现有 SOTA 方法相媲美。同时,Baseline++ 要比 Baseline 表现好很多,说明减少类内变化是现在小样本分类问题设置中的一个重要因素。

消融实验

考虑到一个更深的骨干网络也能够减少类内变化,因此在同一方法上换用不同的骨干网络比较效果,结果如下:

可以看到,更深的骨干网络一般都能够提升各方法的效果。但在 mini-ImageNet 数据集的 5-shot 设置上,一些元方法的效果变差(一种看法是说明,在领域差异较大的情况下,随着特征提取能力的提高,这些方法性能差异越来越大)。考虑到 mini-ImageNet 数据集的基础类与新类的领域差异要比 CUB 数据集更大,因此,接下来通过实验分析这种域差异如何影响小样本分类的效果。

分析领域差异大小对各方法的影响

即分析各方法的跨域能力。在 mini-ImageNet (base class) -> CUB (novel class) 的 5-shot,骨干网络为 ResNet-18 的分类准确率效果如下:

在不同场景下的 5-shot,骨干网络为 ResNet-18 的分类准确率表现对比如下:

可以看到,在 base class 和 novel class 域差异较大时,Baseline 模型表现相对较好。说明现有元学习方法难以适应于域差异与 base support class 过大的新类。而 Baseline 模型简单地基于少数新类别数据微调分类器,允许快速适应新类别并受领域漂移地影响较小。同时,Baseline 模型比 Baseline++ 方法表现更好,可能是因为额外减少类内变化会影响跨域的适应性。

领域适应能力提升的影响

为了让小样本学习方法能够有更好的适应能力,对于 MatchingNet 和 ProtoNet,可以固定特征并训练一个新的 softmax 训练器;对于 MAML,由于初始化方法 MAML 无法固定特征,因此设置为 用 support 更新更多次迭代(实验中设置为 100 次)来训练新的分类层;对于 RelationNet,特征是卷积映射而非特征向量,因此无法用 softmax 替换。作为替代,将新类中的少数训练数据随机分为 3 个 support 和 2 个 query 数据,来用 100 个 epochs 微调关系模块。

实验表明,缺少适应是之前元学习方法比 Baseline 差的原因。因此,在元训练阶段学习去学会适应领域漂移,对于未来的元学习研究是一个重要方向。

量化分析骨干网络深度对类内变化的影响

使用了 [1] 中的 Davies-Bouldin 指数,这是一种评估聚类(在本文中即为类)的紧密度的度量。结论是,使用更深的骨干网络时,base class 和 novel class 的特征的类内变化都会减少。

个人笔记

理解

本文没有提出新颖的模型,而是指出小样本学习领域一些容易被忽视的问题,特别强调了骨干网络(特征提取网络)的能力、数据集的差异性以及领域自适应问题对小样本学习任务的影响。从帮助研究者认清小样本学习领域面临的挑战而言,本文是有价值的。

参考论文

- [1] David L Davies and Donald W Bouldin. A cluster separation measure. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1979.